Что такое LLM и почему они требуют мощных процессоров?

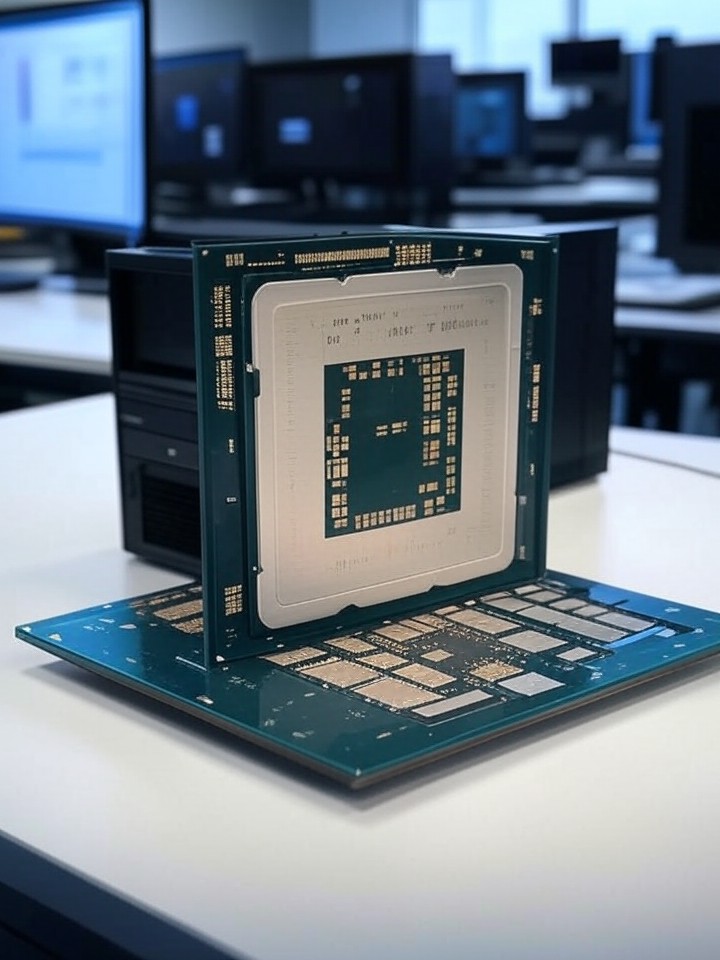

В эпоху искусственного интеллекта большие языковые модели (LLM) стали настоящим прорывом. LLM — это продвинутые системы ИИ, такие как GPT-4 или Llama, которые могут генерировать текст, отвечать на вопросы и даже создавать код. Но за их «магией» стоит огромная вычислительная мощь. Представьте, что LLM — это гигантский мозг, состоящий из миллиардов параметров. Чтобы этот мозг «думал» быстро и эффективно, нужны специализированные процессоры.

Почему обычные компьютеры не справляются? Обучение и работа с LLM требуют параллельных вычислений, где одновременно обрабатываются тысячи операций. Стандартные процессоры не предназначены для такого объема данных, поэтому инженеры разрабатывают чипы, оптимизированные под ИИ. В этой статье мы разберемся, какие процессоры используются для LLM, их типы и перспективы развития. Это введение поможет понять, как технологии меняют наш мир.

Основные типы процессоров для LLM

Процессоры для LLM эволюционировали от универсальных чипов к специализированным. Давайте разберем ключевые виды, их преимущества и применение.

CPU: Классика вычислений

Центральные процессоры (CPU) — это основа любого компьютера. Они отлично справляются с последовательными задачами, но для LLM их мощности часто недостаточно. CPU от Intel или AMD, такие как Xeon или EPYC, используются в начальных этапах разработки моделей, где нужна гибкость.

- Преимущества: Универсальность и поддержка широкого спектра задач.

- Недостатки: Низкая эффективность в параллельных вычислениях, что делает их медленными для больших моделей.

- Пример: В облачных сервисах CPU комбинируют с другими чипами для баланса нагрузки.

Интересный факт: Ранние LLM, как GPT-1, обучались преимущественно на CPU, но сегодня это редкость из-за масштаба данных.

GPU: Короли параллельных вычислений

Графические процессоры (GPU) — настоящие звезды в мире LLM. Разработанные изначально для рендеринга графики, они идеальны для матричных операций, которые лежат в основе нейронных сетей. NVIDIA лидирует с серией A100 и H100, оптимизированными под ИИ.

- Преимущества: Высокая скорость параллельных вычислений, поддержка библиотек вроде CUDA.

- Недостатки: Высокое энергопотребление и стоимость.

- Пример: OpenAI использует тысячи GPU для обучения моделей вроде ChatGPT.

Представьте GPU как оркестр: тысячи ядер работают синхронно, ускоряя обработку данных в разы по сравнению с CPU. Без GPU современные LLM были бы невозможны.

TPU: Специализированные чипы от Google

Tensor Processing Units (TPU) — это чипы, созданные Google специально для задач машинного обучения. Они оптимизированы для тензорных операций, что делает их идеальными для LLM. TPU v4 и v5 используются в Google Cloud для моделей вроде PaLM.

- Преимущества: Эффективность в энергопотреблении и скорости для больших моделей.

- Недостатки: Менее гибкие, чем GPU, и доступны в основном в облаке.

- Пример: TPU помогли Google обучить модели с триллионами параметров.

TPU — это как «спецназ» для ИИ: они решают узкие задачи лучше всех, но требуют интеграции в экосистему Google.

NPU и другие инновации

Нейронные процессоры (NPU) — это новинка, интегрируемая в чипы для мобильных устройств и ПК. Intel и Apple внедряют NPU в свои процессоры (например, в M-series от Apple), чтобы запускать LLM локально без облака.

- Преимущества: Низкое энергопотребление для инференса (работы модели).

- Недостатки: Пока не подходят для обучения гигантских моделей.

- Пример: Microsoft использует NPU в Copilot для Windows.

Будущее за гибридными чипами, сочетающими CPU, GPU и NPU в одном устройстве.

Процессоры в обучении и инференсе LLM

Работа с LLM делится на два этапа: обучение (где модель «учится» на данных) и инференс (где она отвечает на запросы). Процессоры играют разную роль в каждом.

В обучении доминируют GPU и TPU из-за необходимости обрабатывать петабайты данных. Например, обучение GPT-3 требовало тысяч GPU-часов. Здесь важна масштабируемость: суперкомпьютеры вроде тех, что у NVIDIA, объединяют чипы в кластеры.

Для инференса, когда модель уже готова, подойдут и менее мощные процессоры. NPU позволяют запускать LLM на смартфонах, делая ИИ доступным. Оптимизация, такая как квантизация (сжатие модели), снижает требования к hardware.

- Обучение: Требует максимальной мощности, часто в дата-центрах.

- Инференс: Фокус на скорости и энергоэффективности для повседневного использования.

Интересно, что переход к edge computing (локальным вычислениям) меняет рынок: скоро LLM будут работать на ваших часах!

Лидеры рынка: NVIDIA, AMD, Intel и другие

Рынок процессоров для LLM — это битва гигантов. NVIDIA доминирует с 80% долей благодаря экосистеме CUDA. Их чипы A100 и Blackwell — эталон для ИИ.

AMD предлагает альтернативы вроде MI300X, которые дешевле и энергоэффективнее. Intel с серией Gaudi конкурирует в сегменте облачных вычислений.

Другие игроки: Google с TPU, Amazon с Inferentia и даже стартапы вроде Groq, предлагающие чипы для сверхбыстрого инференса.

- NVIDIA: Лидер по производительности.

- AMD: Фокус на цене и доступности.

- Intel: Интеграция в enterprise-решения.

Конкуренция стимулирует инновации, снижая стоимость и повышая доступность LLM для малого бизнеса.

Будущее процессоров для ИИ

Мир процессоров для LLM развивается стремительно. Ожидается рост энергоэффективных чипов, интеграция с квантовыми вычислениями и фокус на устойчивости (снижение углеродного следа дата-центров).

Тренды: Нейроморфные чипы, имитирующие человеческий мозг, и фотонные процессоры на основе света для сверхскоростных вычислений. Компании вроде IBM и Lightmatter уже тестируют прототипы.

Для энтузиастов: открытые проекты, как чипы от Hugging Face, позволяют экспериментировать с LLM на домашнем ПК.

В заключение, процессоры — это фундамент LLM, определяющий их возможности. Понимая эту тему, вы сможете лучше ориентироваться в мире ИИ и даже выбрать hardware для своих проектов. Мир меняется, и процессоры ведут нас в эру умных машин!